开栏的话

人工智能(AI)被视为第四次工业革命,正以前所未有的速度重塑世界,引领各行各业的变革。AI的加入必然会重构企业的业务流程和管理体系,如何顺势而为值得每个企业思考。

海华永泰作为深耕人工智能领域的知名律所,我们深刻理解人工智能的机遇和法律风险,特开辟AI法治前沿系列专栏,分享我们在此领域的实务经验和研究成果,愿助您把握AI时代无限可能,稳健前行。

一、总论

欧盟《人工智能法》采取了以风险为基础的分级监管体系,其中对于高风险人工智能系统的要求相较于禁止使用的人工智能而言较为详细,而相较于较低风险或有限风险的人工智能而言较为严格,应当引起相关提供者与部署者重视。具体而言,对于高风险人工智能系统的合规要求,可分为以下几点。

第一,依据对于人工智能系统分类的基础亦即“风险”,从风险出发,第一个要求即是必须建立、实施、记录、维护和定期更新风险管理系统,用以识别和分析与人工智能相关的已存在和可预见的风险,尽可能消除或降低这些风险,并采取与这些风险相关的控制措施。

第二,由于人工智能的输入与产出的原料是数据,第二个要求即是数据治理,亦即涉及使用数据训练模型的高风险人工智能系统必须加入训练、验证和测试数据集,这些数据集必须经过适当的数据治理和管理实践,具有相关性、代表性、无差错和完整性,并考虑到人工智能系统预期使用场景下的特定地理、行为或功能环境的特征。

第三,基于人工智能算法黑箱的存在,在全生命周期的运行中,要求对于人工智能的使用与运行进行日志留档,并提供给外界必要的透明度和相关信息。具体而言,技术文件应当包含附件四所要求的信息,如对于人工智能系统各要素及其开发过程的详细描述,并保持在生命周期内的更新。在向外界提供信息时,应当保证运行足够透明,使用户能够解释人工智能系统的输出并适当使用,并附有使用说明,便于用户使用和理解。

第四,对于人工智能系统的使用,人类的作用并非仅体现在控制输入和使用输入,立法者还要求自然人对于人工智能系统的监督,要求相关的负责人能够理解系统局限性,并在适当情形下放弃或否决其产出,做到对于系统的干预和监督,必要时停止系统。

第五,对于信息化系统而言,要求产出准确、稳健且安全是降低系统性风险的必要之点,此处要求即是符合其预期目的,并且必须在随附使用说明中声明准确性指标,且能够抵御错误、故障,抵御有意利用系统漏洞第三方的攻击。

第六,对于立法的核心:安全与基本权利,立法者要求提供者对于系统可能产生的对于基本权利的影响进行评估。本文将着重介绍风险管理系统与数据治理要求。

二、风险管理系统

(一)风险管理系统总论

第9条第1款应当建立、实施、记录和维护与高风险人工智能系统有关的风险管理系统。

第9条第6款 应当测试高风险人工智能系统,以确保风险管理措施最为适当且最有针对性。此种测试应确保高风险人工智能系统能始终如一地达到预期目的,并符合本节所规定的要求。

风险管理系统(Risk Management System)作为对于高风险人工智能系统的第一个合规要求,不仅反映出了立法者对于全生命周期下监管调制风险的决心,更与以风险为基本划分尺度的分级标准相对应。

鉴于人工智能产出的非线性过程,风险管理系统的概念并不是首次提出,在美国国家标准与技术研究院的人工智能风险管理框架(U.S. National Institute of Standards and Technology AI Risk Management framework)中的第二部分[4]便已创制了一种全生命周期、基于不同场景的风险管理方案,分为四个环节:治理—规划—评估—管控(Govern-Map-Measure-Manage),分别对应明确监管者职责和明确人类部分的决策过程和分工,规划技术和决策流程,使用混合工具评估风险与影响和记录系统性能和可信度,以及利用评估结果管控风险或调整功能。

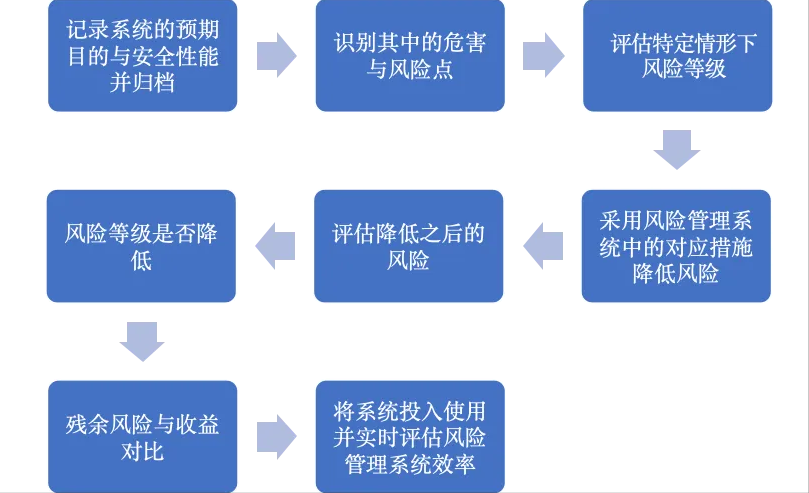

通过以上比较不难看出,风险管理系统要求产品提供者通过特定流程记录责任分配、风险管理步骤以及用于评估和评价风险的方法,包括确定风险等级的严重性和发生可能性。下图是一种风险管理系统的流程示例,提供者在在产品商业化后亦须产品进行监控,必要时更新风险管理档案,并在出现新风险或低估风险时补救。

图2.2.1 一种风险管理系统决策流程图

传统的产品安全与风险管控立法聚焦于人身健康与人身安全,而欧盟《人工智能法》则首先将风险范围划定为“与高风险人工智能有关”的“已造成”和“可预知”的风险,并补充风险应当通过测试评估,这种测试的流程应当至少和高风险系统实际投入使用并达到预期目的的流程保持一致,这样才能够最大程度上发现潜在风险,提前部署应对措施。其次,《人工智能法》将管理扩展至对于基本权利的保护,例如个人数据、隐私与非歧视,明确风险评估与管理应当考虑对于基本权利的侵犯问题,应当以《欧盟基本权利宪章》(The Charter of Fundamental Rights of the EU)所列明的五十项基本权利为标准逐一核对,但具体审核与更新的标准尚不明确,欧盟后续立法应当给出审核标准和风险收益在涉及基本权利下的权衡情形,用以指导企业合规。

图2.2.2 依据风险严重性与发生可能性制作的评估矩阵

需要说明的是,第一款中说明了风险管理系统落实的环节:“建立、实施、记录、维护”,分别应当作以下解释:若企业制定了有关特定高风险人工智能系统的风险管理政策、流程或指示,并得到了决策者批准,则可认为已建立;若已落实,亦即员工了解措施的预期目的并能够采取相应行动,则可认为已实施;记录要求有可查可及文件,维护要求定期审查并保持更新。

(二)风险管理措施

第9条第2款风险管理系统应被理解为在高风险人工智能系统的整个生命周期内规划和运行的一个持续迭代过程,需要定期进行系统审查和更新。其应包括以下步骤:

a. 确定和分析高风险人工智能系统在按照其预期目的使用时可能对健康、安全或基本权利造成的已知和可合理预见的风险;

b. 预测和评估当高风险人工智能系统按照其预期目的使用时和在可合理预见的误用情 况下可能出现的风险;

c. 根据对从第72条所指的上市后监测系统收集到的数据的分析,对可能出现的其它风 险进行评估;

d. 采取适当的、有针对性的风险管理措施,以应对根据第9条第2a款所确定的风险。

第9条第3款 本款所指的风险只涉及那些通过开发或设计高风险人工智能系统或提供充分的技术信息可以合理地减轻或消除的风险。

第9条第4款 第9条第2d款所指的风险管理措施应适当考虑第二章规定各项要求综合应用下所产生的影响和可能的相互作用,以便更有效地把风险降到最低,同时在实施满足这些要求的措施时取得适当的平衡。

第9条第5款 第9条第2d款所指的风险管理措施应使与每种危险相关的残余风险以及高风险人工智能系统的总体残余风险被判定为可以接受。在确定最适当的风险管理措施时,应确保以下几点:

a. 通过充分设计和开发高风险人工智能系统,在技术上可行的情况下,消除或减少根据本条第2款确定和评估的风险;

b. 针对无法消除的风险,酌情采取适当的缓解和控制措施;

c. 提供第13条所规定的必要信息,并酌情对部署者进行培训。出于消除或减少与使用高风险人工智能系统有关的风险的考虑,应适当考虑部署者的技术知识、经验、教育、预期的培训以及意图使用该系统的假定环境。

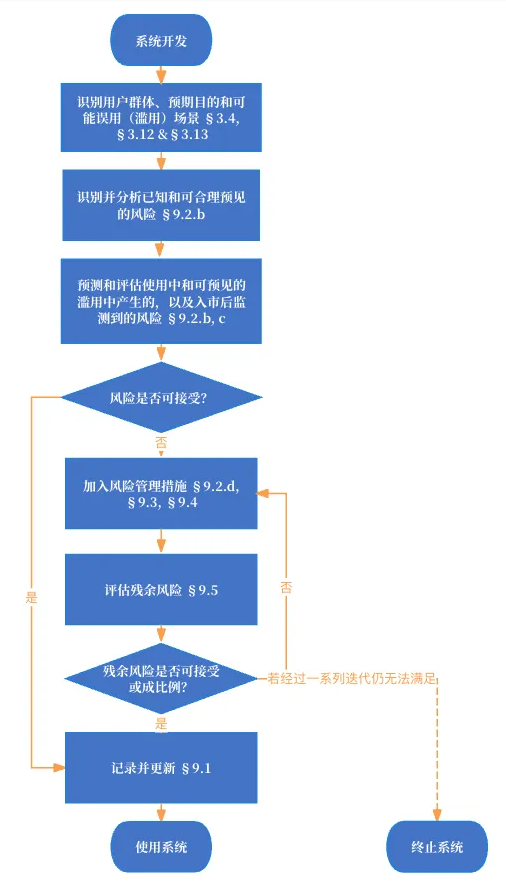

纵观第二至第五款,可以发现其中加入了很多标准,例如要求评估“对于基本权利”的“已造成”和“可合理预见”的风险,然而欧洲标准化委员会(The European Committee for Standardization, CEN)和欧洲电工标准化委员会(the European Committee for Electrotechnical Standardization, CENELEC)并不愿意设定与基本权利相关风险的可接受性阈值作为标准,针对本条所制定的标准可能尚需时日。值得注意的是既存的企业风险管理框架(ERM framework)亦可被应用于人工智能语境。在早期《欧盟人工智能法》草案版本中,本条第三款有标准补强的规定,被明确为“协同标准与统一规格”(Harmonised standards and common specifications),亦即合规推定(Presumption of Conformity),在缺乏统一标准的领域,欧共体能够制定统一规格,这种规格一般低于特定标准但高于基本标准,例如利用诸如NIST人工智能风险管理框架或国际标准化组织人工智能风险管理框架(ISO/IEC DIS 23894)这样的国际标准为统一规格,并将其纳入欧盟标准制定考量,现阶段相关标准可以以上标准作以基本参考。

图2.2.3 风险管理系统流程示意

第2a款 根据已有标准参考,不难对“已造成”和“可合理预见”的风险加以解释,“已知”亦即“已造成”,就是此类风险过去已经发生,且由于其发生的条件并非偶然的,将来必然发生的风险,这与企业是否在拟定管理方案或制作系统时是否实际知道这一风险发生过无关,而应当将其解释为一种应然的、经过合理审慎评估和搜索可以得知的。相比之下,“可合理预见”的关键在于合理性,这里又涉及到了上文提到过的风险与收益的对比问题,涉及到近似于比例均衡的估算。由于标准并不明晰,笔者建议企业在此处评估风险的潜在影响群体、影响的权利、影响的时空范围等因素确定是否大到需要预见并克服。

第2b款及第2c款 对于适用范围,应当包括依照其设计目的使用过程中以及“可预见的误用(滥用)”过程中产生的风险,这一规定相比最初版本的草案将范围扩展至合理预见的误用,进一步明确了企业应当建立一个将产品投入市场或投入使用后监管系统(下称入市后监管系统),来应对扩展后的适用范围。这也和第一款所规定的“全生命周期”风险管控是一致的,提供者应当能够知晓产品的可能用处的界限,并以建立入市后监管系统为合规要件,是对于企业监管责任的强化。

第2d款 对于采取何种手段,立法解释上应当是“适当”且“有针对性”的,分别而言,“适当”意味着这样的风险管理系统中的各个措施并不是单一线性、一字摆开、一蹴而就的,而应当是一个迭代的过程,亦即重复进行并不断细化风险评估,直到残余风险与使用获益能够成比例,前者明显低于或弱于后者,前者的侵益性显著低于后者的优益性;“有针对性”意味着应当是针对这一特定人工智能系统部署的风险管理流程,不能对性质、机理和预期目的不同的人工智能系统作以嵌套式的风险管理评估。

第3款 对于本条所指的风险范围,应当解释为“目前已经认知”且可以通过“合理手段”予以预防或减弱的风险,并不包含算法本身最大的黑箱风险,因为目前尚不存在解决此类风险的技术手段,将其拟定入风险管理莫过于苛求提供者,也不利于产业发展。笔者认为,此种风险的标准应当是是否能够证明存在既有成功克服此类风险的案例,或是否在技术操作上可能克服此类风险。若是,且此风险出现或预期将出现于使用或误用中,则提供者应当将其纳入评估管理范围。

第4款 风险管理措施在自身作为一个整体流程迭代的同时,也要考虑到内部各个环节之间的相互影响作用的问题,例如算法串流、数据冗余等问题对于风险评估和降低措施有效性的影响。这种影响并非一定是负面的,也可能是加强风险防控,但可能会降低效率提高成本,甚或使系统无法达到预期目的运行。立法者在此处强调的并不是滴水不漏、万无一失的风险管理措施,而是达到风险、权益和收益之间的“平衡”。至于平衡的基点在哪里,则需要后续标准和案例进一步补充。

第5款 残余风险亦即在第一次(或上一次)风险措施实施之后,仍未能克服或降低的风险。立法者深谙人工智能算法黑箱所带来风险的必然性,因而此处的风险管理系统并不是一劳永逸得解决风险,而是将残余风险控制在可以接受的范围内,也就是推动设计上的高风险人工智能系统在使用上向可接受风险人工智能系统靠拢。是否可接受,这一标准应当考虑技术标准、社会普遍价值、系统应用的场景、收集的信息和提供给用户的信息、用户的知情同意情况以及负责风险管理和人工监督个人的能力。

详言之,风险管控应当是以下路径:首先,发现并评估风险;其次,在最表面的层面上对于模型或算法进行微调;再次,采取减缓的风险管理措施;最后,向部署者提供信息告知风险存在,并结合应用场景和目标群体(部署者专业程度)予以降低风险的指导,使提供者和部署者共同降低使用此类人工智能系统所可能带来的风险。

(三)风险测试程序

第9条第7款 测试程序可包括根据第60条在真实世界条件下进行的测试。

第9条第8款 对高风险人工智能系统的测试应酌情在整个开发过程的任何时候进行,无论如何都应在投入市场或投入服务之前进行。应根据事先确定的指标和概率阈值进行测试,这些指标和阈值应与高风险人工智能系统的预期目的相适应。

为评估风险等级以进一步确定应当采取的措施,立法进一步明确风险测试程序,此种措施应当确保人工智能系统能够一如既往地达到预期目的。之所以立法者对于预期目的如此强调,原因应有以下两点:首先,预期目的作为系统的书面材料之一,能够确定系统涉及的个人权利和影响群体的范围,以便于细化风险管理及以下各种措施;第二,由于测试环境与使用环境的实质不同,变量要素和环境复杂性都会大相径庭,尽管欧盟试图通过算法监管沙箱弥合这一差距,但资料漂移(Distributional Shift, 一译分布偏移)会降低评估当前策略在固定数据集中有效样本的大小,使欲达致的策略与目标渐行渐远,需要预期目的作为评估措施有效性的最后手段和标准。

第8款 与风险管理系统不同,风险测试程序并不要求贯穿全生命周期各个环节,只需要在整个开发过程中选择适当的时点进行,亦即何时进行风险测试是由提供者决定的,但最迟不得晚于系统入市或使用之前。至于应当如何测试,立法者给出了两个标准的参考:确定指标和概率阈值,前者指的是评估基准和关键绩效指标(KPI),后者指的是通过一个或多个预先定义的阈值概率评估某一属性并分类的方法。由于尚无标准或实践,此处的指标和阈值建议参考上文提到的统一标准确定。

(四)与内部风险程序要求的统一

第9条第10款 对于高风险人工智能系统的提供者而言,如果其内部风险管理流程须符合相关欧盟部门法律的要求,则本条第1款至第9款所述方面可作为根据该法律制定的风险管理程序的一部分,或与之相结合。

对于诸如金融信贷机构之类的企业,风险管理程序一般业已存在,此时此条下各措施要求应当是对于已有程序的补充,而非另立门户或取而代之。惟须注意的是,是否能够以内部风险管理程序作为本条下针对人工智能系统风险管理措施的替代,立法者虽未对此加以明确,从文意解释上答案是否定的,“作为一部分”和“结合”表明应当是补强的关系,而并非是同类替代或减轻附加义务。

在明确法案对风险管理系统的相关要求后,下一篇系列文章将介绍高风险人工智能系统中数据训练和数据治理的合规要求。

律师简介

王进

海华永泰高级合伙人

王进,海华永泰律师事务所高级合伙人、科创业务委员会主任。华东政法大学法律硕士、复旦大学EMBA、复旦大学法学院实务讲师,近20年律师行业经验。专注于公司与商事、复杂案件争议解决、科创与高科技等领域。在人工智能与数字经济方面,对人工智能合规与企业风险应对、数据合规与交易、网络安全领域有深入的研究和丰富的经验。

乔恒祥

海华永泰律师助理

中国政法大学法学硕士。专注于人工智能、数字经济行业等科创行业领域。

陈禹廷

本科就读于同济大学法学专业,参与上海市人工智能协同治理中心全球人工智能治理数据库等项目,担任AI-Law等组织负责人。

编辑:秦正